محاسبات علمی و تحلیل دادههای بزرگ با NVIDIA A100 Tensor Core GPU

NVIDIA A100 Tensor Core GPU به عنوان یکی از قویترین و پیشرفتهترین پردازندههای گرافیکی برای هوش مصنوعی، تحلیل داده و محاسبات با کارایی بالا (HPC) شناخته می...

لیست مطالب

- دلایل تولید A100

- قابلیتها و ویژگیهای کلیدی A100

- کاربردهای NVIDIA A100

- مقایسه A100 با سایر GPUها

- آمار و ارقام

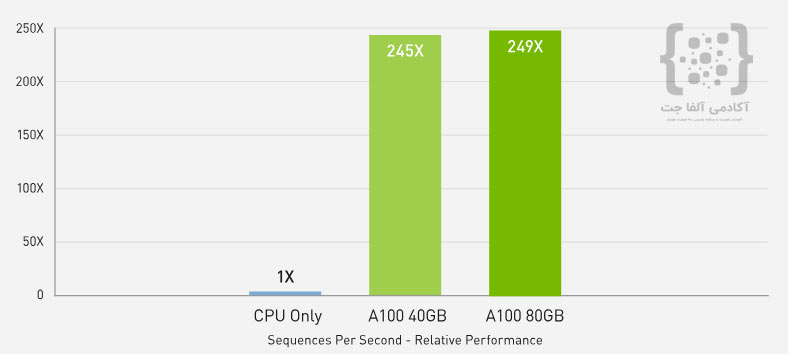

- افزایش تا 249 برابری عملکرد استنتاج هوش مصنوعی با NVIDIA A100 نسبت به CPU

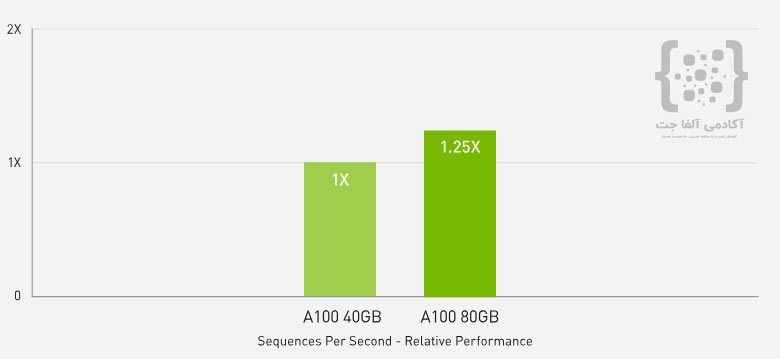

- 1.25 برابر عملکرد بهتر در استنتاج هوش مصنوعی با A100 80GB نسبت به A100 40GB

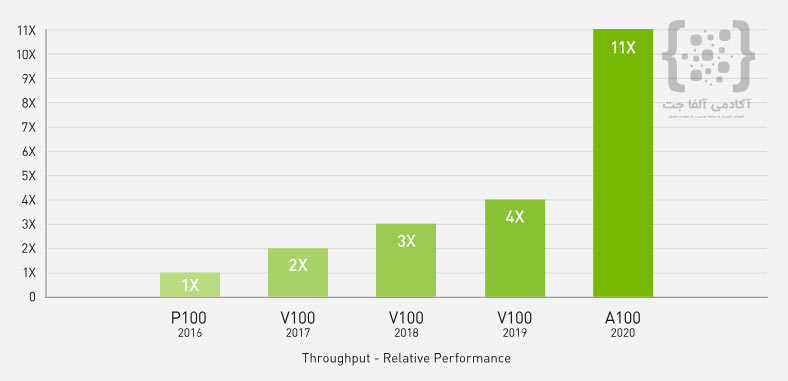

- 11 برابر افزایش عملکرد HPC در چهار سال با NVIDIA A100

NVIDIA A100 Tensor Core GPU به عنوان یکی از قویترین و پیشرفتهترین پردازندههای گرافیکی برای هوش مصنوعی، تحلیل داده و محاسبات با کارایی بالا (HPC) شناخته میشود. این محصول بخشی از پلتفرم مرکز داده NVIDIA است که تسریع فوقالعادهای را در هر مقیاس ارائه میدهد و به طور خاص برای تسریع مراکز داده الاستیک طراحی شده است.

دلایل تولید A100

A100 برای پاسخگویی به نیازهای روزافزون در حوزههایی مانند هوش مصنوعی، یادگیری عمیق و محاسبات علمی تولید شده است. افزایش حجم دادهها و پیچیدگیهای مدلهای یادگیری عمیق و نیاز به تسریع محاسبات علمی، ضرورت طراحی GPUهایی با کارایی بیشتر را ایجاد کرد. NVIDIA A100 برای حل این چالشها با ارائه توان پردازشی بیسابقه در تمامی مقیاسها ساخته شده است.

این GPU میتواند تا 20 برابر عملکرد بیشتری نسبت به نسل قبلی Volta ارائه دهد و به شکل بهینهای برای مراکز داده بزرگ طراحی شده است. همچنین با قابلیت تقسیم به هفت نمونه GPU مجزا (MIG)، این پلتفرم بهینهسازی منابع و تنظیمات پویا برای بارهای کاری مختلف را امکانپذیر میسازد.

قابلیتها و ویژگیهای کلیدی A100

1. تسریع در تمامی بارهای کاری

A100 با استفاده از هستههای Tensor نسل سوم، 312 ترافلاپس (TFLOPS) قدرت پردازشی در یادگیری عمیق ارائه میدهد، که این مقدار در مقایسه با نسل قبلی (Volta) تا 20 برابر افزایش یافته است. این توان پردازشی میتواند محاسبات پیچیده یادگیری عمیق و علمی را به طور قابل توجهی تسریع کند.

2. حافظه HBM2e

A100 از حافظه HBM2e با ظرفیت 80 گیگابایت بهره میبرد که پهنای باندی بیش از 2 ترابایت بر ثانیه ارائه میدهد. این سرعت بالا، امکان پردازش سریعتر مدلهای بزرگ و دادههای عظیم را فراهم میکند.

3. فناوری Multi-instance GPU (MIG)

MIG یکی از ویژگیهای مهم A100 است که به کاربران اجازه میدهد GPU را به چند نمونه کوچکتر و مستقل تقسیم کنند. این ویژگی بهینهسازی مصرف منابع GPU و افزایش کارایی مراکز داده را ممکن میسازد.

4. پشتیبانی از دقتهای متنوع محاسباتی

A100 از انواع دقتهای محاسباتی، از جمله FP64، FP32، و INT8 پشتیبانی میکند که این تنوع باعث افزایش انعطافپذیری در اجرای بارهای کاری مختلف میشود.

5. ساختار پراکندگی (Sparsity)

A100 با بهرهگیری از ویژگی sparsity، عملکرد مدلهای یادگیری عمیق را بهبود میبخشد. این ویژگی، بدون کاهش دقت، باعث افزایش سرعت پردازش مدلهای هوش مصنوعی میشود.

کاربردهای NVIDIA A100

1. یادگیری عمیق و هوش مصنوعی

A100 بهطور گسترده در آموزش و استنتاج مدلهای یادگیری عمیق استفاده میشود. با توانایی بالای محاسبات ماتریسی و پردازش موازی، این GPU قادر است زمان آموزش مدلهای هوش مصنوعی را به طور چشمگیری کاهش دهد.

2. تحلیل دادههای بزرگ

تحلیل دادههای بزرگ نیاز به پردازش سریع و کارآمد دارد. A100 با حافظه پرسرعت و پشتیبانی از فناوریهایی مانند MIG، به تحلیلگران داده اجازه میدهد دادههای عظیم را به سرعت پردازش کنند.

3. محاسبات علمی و شبیهسازیها

NVIDIA A100 برای محاسبات علمی پیچیده، مانند شبیهسازیهای فیزیکی، شیمیایی و بیولوژیکی، طراحی شده است. این GPU با پشتیبانی از محاسبات دقت بالا (FP64) و توان پردازش موازی، به تسریع فرآیندهای محاسباتی کمک میکند.

4. مراکز داده و سرویسهای ابری

A100 به عنوان بخشی از زیرساخت مراکز داده و سرویسهای ابری استفاده میشود. این GPU با قابلیتهای منحصر به فرد مانند NVLink و MIG، امکان بهینهسازی بارهای کاری مختلف را در مراکز داده فراهم میکند.

مقایسه A100 با سایر GPUها

A100 در مقایسه با سایر GPUهای موجود در بازار مانند V100، بهبودهای قابل توجهی داشته است. به طور خاص، پهنای باند حافظه و توان پردازش موازی A100 از مهمترین مزایای آن در برابر نسل قبلی است.

| ویژگی | NVIDIA A100 | NVIDIA V100 |

|---|---|---|

| تعداد هسته CUDA | 6,912 | 5,120 |

| حافظه | 80GB HBM2e | 16GB HBM2 |

| پهنای باند حافظه | 2TB/s | 900GB/s |

| توان پردازشی FP32 | 19.5 TFLOPS | 15.7 TFLOPS |

| توان پردازشی Tensor | 312 TFLOPS | 125 TFLOPS |

آمار و ارقام

- زمان آموزش مدلهای یادگیری عمیق: A100 میتواند زمان آموزش مدلهای بزرگ هوش مصنوعی را تا 20 برابر سریعتر از نسل قبلی V100 کاهش دهد.

- سرعت اجرای مدلهای هوش مصنوعی: این GPU در اجرای مدلهای AI تا 249 برابر سریعتر از CPUها عمل میکند.

- افزایش بهرهوری انرژی: A100 با بهرهگیری از فناوری MIG، امکان مدیریت بهینه مصرف انرژی را در مراکز داده فراهم میکند.

افزایش تا 249 برابری عملکرد استنتاج هوش مصنوعی با NVIDIA A100 نسبت به CPU

در نمودار نمایش داده شده، عملکرد استنتاج مدل BERT-LARGE با NVIDIA A100 در مقابل CPU بررسی شده است. نتایج نشان میدهد که A100 در نسخههای 40GB و 80GB میتواند به ترتیب تا 245 و 249 برابر سریعتر از پردازندههای Xeon Gold 6240 عمل کند. این بهبود قابل توجه در نتیجه استفاده از دقت INT8 و فناوری sparsity در A100 بهدست آمده است. این پیشرفت، نشاندهنده قدرت A100 در اجرای عملیاتهای سنگین هوش مصنوعی و یادگیری عمیق در مقایسه با سیستمهای مبتنی بر CPU است.

1.25 برابر عملکرد بهتر در استنتاج هوش مصنوعی با A100 80GB نسبت به A100 40GB

نمودار فوق نشان میدهد که عملکرد استنتاج هوش مصنوعی با مدل RNN-T در NVIDIA A100 نسخه 80 گیگابایتی، تا 1.25 برابر سریعتر از نسخه 40 گیگابایتی است. این بهبود عملکرد در استنتاج تک جریان (Single Stream) با استفاده از دقت FP16 و چارچوب TensorRT به دست آمده است. افزایش حافظه و پهنای باند بیشتر در A100 80GB، امکان پردازش سریعتر دادهها را در این نسخه فراهم کرده و نتایج قابل توجهی در مقایسه با نسخه 40GB ارائه میدهد.

11 برابر افزایش عملکرد HPC در چهار سال با NVIDIA A100

نمودار نشان میدهد که عملکرد محاسبات با کارایی بالا (HPC) با استفاده از NVIDIA A100 تا 11 برابر نسبت به P100 در طی چهار سال افزایش یافته است. در مقایسه با V100، عملکرد A100 تا 2.75 برابر سریعتر است. این نتایج بر اساس میانگین هندسی برنامههای HPC معتبر مانند Amber، GROMACS، PyTorch و TensorFlow است. این افزایش چشمگیر ناشی از پیشرفتهای فناوری مانند نسل سوم Tensor Cores و حافظه HBM2e در A100 است که به تسریع محاسبات علمی و صنعتی کمک کرده است.

دیدگاه های مربوط به این مقاله (برای ارسال دیدگاه در سایت حتما باید عضو باشید و پروفایل کاربری شما تکمیل شده باشد)